Диагностика и снятие фильтров поисковых систем — одна из распространённых проблем при работе над продвижением сайта. Часто вебмастера и даже некоторые оптимизаторы не умеют распознавать наложенные фильтры. Для них эта статья.

Для начала разберёмся с тем, какие фильтры имеют в своём арсенале две самые крупные поисковые системы — Google и Яндекс.

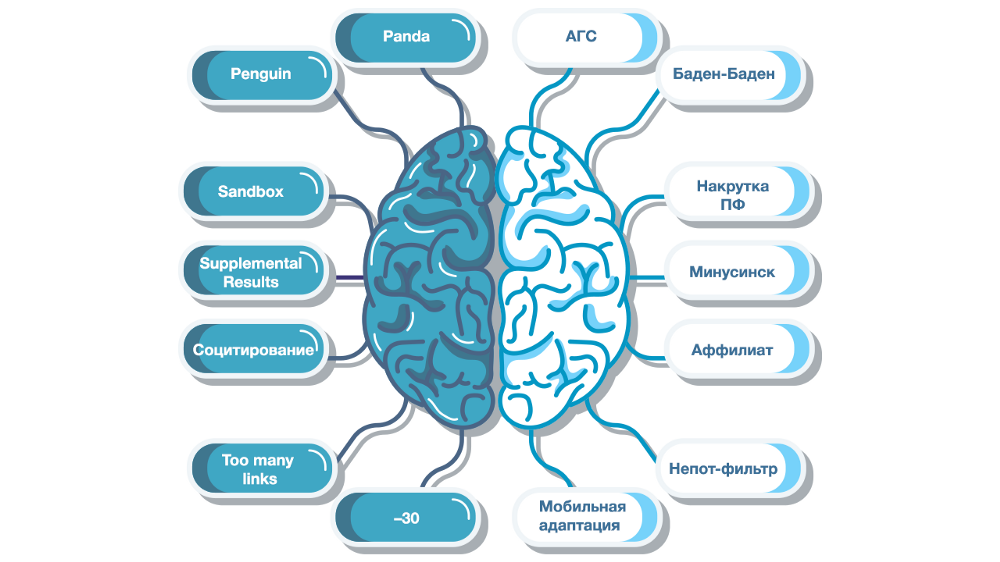

1. Panda — алгоритм Google, оценивающий качество сайтов в целом и контента, в частности. Фильтр, наложенный на сайт, лишает его трафика, перераспределяя последний в пользу других ресурсов. Panda оценивает ресурсы по следующим критериям:

· качество контента;

· наличие дублированного контента;

· плагиат;

· функциональность, юзабилити и дизайн сайта;

· избыточное количество и навязчивое размещение рекламы.

2. Penguin — алгоритм Google, который борется с манипулятивным линкбилдингом. В это понятие входят практически все искусственные способы наращивания внешней ссылочной массы: покупка ссылок, ссылочный спам на форумах и в блогах, публикация ссылок на аффилированных ресурсах, спам, в т.ч., замаскированный под гостевой постинг, злоупотребление SEO-анкорами, публикация невидимых для пользователей ссылок.

Данный фильтр накладывается не на сайт в целом, а на конкретные страницы. Фильтр не наказывает за манипулятивные ссылки, а обнуляет их влияние на ранжирование. Иначе говоря, он отменяет влияние ссылок на ранжирование конкретных документов.

3. Sandbox (песочница) — фильтр, ограничивающий посещаемость недавно созданных сайтов. Задача данного фильтра — препятствовать попаданию таких сайтов в топ выдачи Google по высокочастотным запросам, как коммерческим, так и информационным.

Введён для борьбы со спамом и сомнительными сайтами. Срок вывода сайта по самым топовым запросам может быть более 5 месяцев.

4. Supplemental Results — фильтр, помещающий в дополнительный индекс документы, отнесённые алгоритмом к недостаточно качественным и ценным для пользователей. Обычно применяется к документам, не имеющим оригинального контента.

5. Социтирование — фильтр, пессимизирующий сайты, «окруженные плохими соседями». Google может ухудшить ранжирование сайта по тематическим запросам, если наблюдается значимое количество нетематических доноров.

6. Too many links — фильтр, который накладывается при «ссылочном взрыве», т.е. если сайт обзаводится большим количеством доноров за короткий промежуток времени. Сайт может быть пессимизирован также в случае, если за короткое время на нём появится очень много страниц.

7. Битые ссылки — часть алгоритма, отвечающего за качество ресурсов.

Когда ссылка ведет на отсутствующую страницу, то поисковый робот не может до неё добраться. И, как следствие, не может поместить её в индекс и закэшировать (Google Cache). Это может плохо сказаться на результатах поиска, а также на общих показателях качества сайта.

8. «–30» — фильтр, направленный на борьбу с дорвеями и редиректами. При злоупотреблении перенаправлениями, сайт теряет 30 позиций в выдаче по всем запросам.

9. Дублированный контент — алгоритм, оценивающий качество ресурса. Лишает сайты-плагиаторы части трафика.

10. Переоптимизация — фильтр, использующийся, если на сайте применяются следующие манипуляции:

11. Фильтр за медленную загрузку страниц — фильтр, лишающий трафика ресурсы, не удовлетворяющие пользователей по техническим параметрам. При этом происходит падение позиций сайта в выдаче в целом или снижение позиций только в мобильной выдаче.

12. Фильтр за отсутствие оптимизации под мобильный трафик — часть поискового алгоритма, понижающая в мобильной выдаче ресурсы без адаптивной верстки или мобильной версии.

В ближайшее время мобильный индекс станет основным. Поэтому адаптация сайта под мобильный трафик обязательна.

1. АГС — один из самых известных фильтров Яндекса, использующийся для борьбы с поисковым спамом и некачественными сайтами. АГС накладывается на сайты низкого качества (малоинформативные или состоящие преимущественно из неуникальных материалов), а также на сайты, участвующие в манипуляциях алгоритмом ранжирования путём простановки SEO-ссылок.

2. Баден-Баден — фильтр за переоптимизацию, наказывающий сайты, злоупотребляющие ключевыми фразами. Чтобы избежать данного фильтра, рекомендуем воспользоваться услугой «Написание текстов для сайта» от Wizard.Sape.

3. Фильтр за накрутку поведенческих факторов — фильтр, накладывающийся за имитацию действий пользователей.

4. Минусинск — фильтр, определяющий сайты, которые используют SEO-ссылки для поискового продвижения, и понижает эти сайты в ранжировании (обычно на 20 позиций по всем запросам) на срок от одного до нескольких месяцев.

По наблюдениям Wizard.Sape, в течение последнего года Минусинск не накладывался. В целом, оптимизаторы стали более аккуратно набирать ссылочную массу, отдавая предпочтение качеству, а не количеству.

5. Аффилиат-фильтр — фильтр для борьбы с монополизацией поисковой выдачи путём создания множества сайтов сходной тематики. Сайты считаются аффилиатами, если у них совпадают:

· хостинг;

· данные whois у доменов;

· тематика;

· адрес и название фирмы;

· IP-адреса и т.д.

Аффилированные сайты Яндекс удаляет из поисковой выдачи, оставляя только ресурс, который его алгоритмы определили, как главный.

6. Непот-фильтр — фильтр для борьбы с торговлей ссылок. Накладывается на сайты, участвующие в линкоторговле, с целью минимизации передачи с них ссылочного веса. Ухудшения ранжирования таких сайтов не происходит.

7. Санкции за взрослый контент — при наличии на сайте материалов категории 18+, Яндекс лишает его трафика по запросам, не относящимся к взрослой тематике. Чтобы избежать этого фильтра, не следует публиковать adult-контент.

8. Пессимизация за отсутствие адаптации к мобильному трафику — фильтр, который лишает мобильного трафика сайты, которые неудобно просматривать на экранах смартфонов и планшетов.

В первую очередь, обратите внимание на следующие признаки:

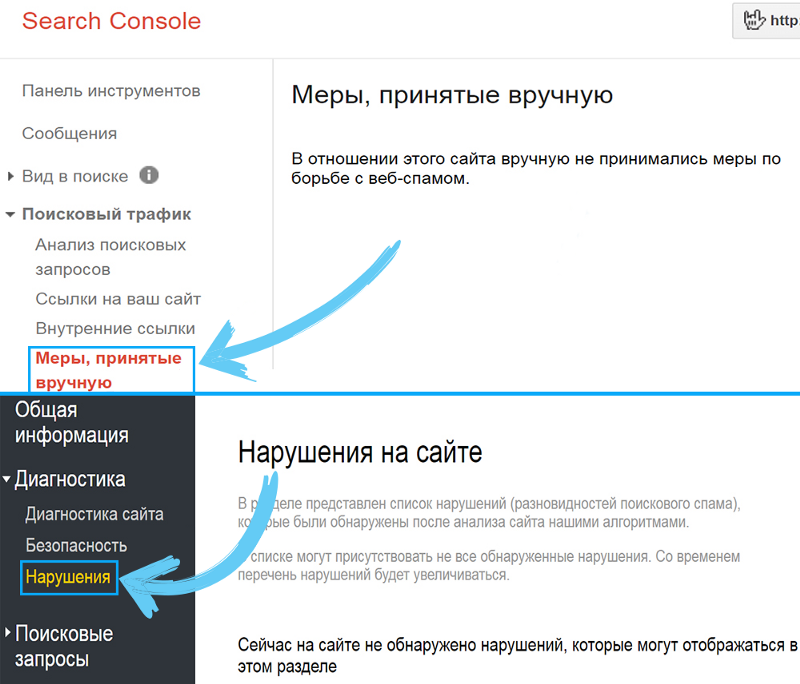

Чтобы своевременно обнаружить санкции поисковых систем, используйте инструменты Search Console Google и Яндекс.Вебмастер, а именно, разделы «Меры, принятые вручную» и «Нарушения» соответственно.

Если же, при явном наличии проблем, в данных разделах будет сообщаться об отсутствии таковых, то придется производить более глубокую проверку.

Существуют следующие сервисы диагностики фильтров поисковых систем:

1) PR-CY.ru — универсальный сервис для анализа сайтов, который, кроме обилия полезной информации касательно оптимизации под поисковые системы, также помогает определить фильтр Яндекса.

2) CY-PR.com — сервис, выполняющий комплексный анализ, в том числе, и проверку сайта на санкции Яндекса и Google.

3) Website Penalty Indicator — сервис поможет в случае, если вы обнаружили резкое падение трафика из Google и потерю позиций по ключевым запросам. После анализа сайта сервис выдаст график изменений трафика из Google с наложением временных маркеров, соответствующих апдейтам Panda и Penguin.

Таким образом можно проследить, когда случались самые резкие падения позиций, выяснить, не совпадали ли они с апдейтами соответствующих алгоритмов и поискать причины среди производимых действий (публикация неуникальных материалов, покупка ссылок и т.д.).

Чтобы, продвигая сайт, избежать фильтров от поисковых систем, нужно проводить комплексную работу над сайтом: улучшать его и делать удобнее для пользователей.

Основные рекомендации:

1) Наполняйте свой сайт только уникальным контентом.

2) Не увлекайтесь чрезмерной оптимизацией текстов под ключевые запросы.

3) Избегайте резких изменений внешней ссылочной массы. В системе Wizard.Sape для этого есть опция «Контроль ссылочного взрыва».

4) Формируйте качественный ссылочный профиль сайта. Хорошим дополнением для классических арендных ссылок являются крауд-ссылки: обычно они размещаются без анкора и распознаются алгоритмами поисковых систем как естественные.