Для Google важен показ в поисковой выдаче сайтов с качественным контентом. Появление новых алгоритмов постепенно совершенствует этот процесс. Каждый фильтр ― это часть алгоритма. Он может понизить позиции сайта, или вообще исключить его из поисковой выдачи.

Как понять, что Гугл наложил фильтры? При наложении на ресурс санкций администратору сайта не отправляется уведомление. Определить это можно только по изменениям в трафике. Своевременно принятые меры позволят вывести сайт из-под фильтров.

Поисковик может наложить ограничения на сайты любого возраста и масштаба. Более придирчивое отношение наблюдается к недавно созданным ресурсам. Грамотная и постепенная оптимизация поможет снять ограничения через несколько месяцев.

Далее будут описаны действующие фильтры и санкции Google, их проявление, диагностика и устранение причин.

До сих пор ведутся споры, на самом ли деле существует фильтр под названием “Песочница”. По правилам Гугл в “песочницу” попадают все новые сайты. Однако и к старым сайтам может быть применен этот фильтр, если будут замечены нарушения в продвижении. Ограничение может составлять до 6 месяцев.

Для того, чтобы не попадать в SandBox или выйти оттуда необходимо:

Для доменов со стажем, при подозрении в попадании в песочницу, необходимо временно ограничить высокочастотные запросы и перейти на низкочастотные. После выравнивания трафика можно вернуться к ВЧ запросам.

Фильтр Панда появился в 2011 году. Его задача следить за качеством контента. Попасть под этот фильтр можно за отсутствие на ресурсе ческой тематики и наличие малоинформативных текстов с большой “водой”.

Плохие поведенческие показатели в виде возврата на главную страницу выдачи после захода на сайт также могут увести сайт под фильтр Panda. На поведенческих факторах отрицательно сказывается неработающий функционал ресурса.

Для снятия санкций Панда необходимо выполнить следующее:

Обновление Панды происходит ежемесячно. При попадании под фильтр и устранении недочетов санкция будет снята. Иногда этот процесс может длиться в течение нескольких обновлений фильтра.

Запуск Пингвина состоялся в апреле 2012 года с целью борьбы со спамом, якорными текстами и нерелевантными ссылками.

В 2016 году произошло его последнее обновление, после которого было снято наказание за спамные ссылки. Сайт просто начинает терять свои позиции в поисковой выдаче.

Определить попадание под фильтр можно по сообщению в Google Search Console о подозрении в использовании искусственных ссылок. После этого у сайта начинается плавный или резкий обвал в позициях Google.

Как снять санкции Пингвина:

Иногда для выхода из-под фильтра нужно отправлять несколько запросов.

Фильтр появился в 2018 году, однако полноценным фильтром его трудно назвать. Speed Update влияет на сайты с медленной загрузкой и мобильную выдачу. Сайты с большей скоростью загрузки лучше ранжируются в алгоритме. Медленная загрузка приводит к понижению позиций. Под наблюдение Апдейта не попадают ресурсы со средней и быстрой загрузкой.

Мобильный индекс будет все больше обращать внимание на адаптивную или мобильную версию сайтов.

Для сохранения позиций в выдаче у ресурса должны быть:

Слишком большое количество ссылок одновременно. Сейчас эту ситуацию отслеживает “Пингвин”.

Раньше признаками попадания под Too many links at once было резкое снижение трафика от Гугл, а новые купленные ссылки игнорировались. В свою очередь существующие внешние ссылки не оказывали влияния на позиции сайта.

В основном санкция использовалась для молодых ресурсов. Если сайту примерно 6 месяцев, то лучше закупать 1-2 ссылки в день. Затем, если входящие ссылки были качественными, закупку можно увеличить до пяти.

Колибри ― фильтр на половинку. Санкции не накладывает, но снижает позиции в выдаче. Работает с 2013 года и ведет проверку семантического ядра на соответствие его теме ресурса. Простыми словами пользователь по своему запросу должен попадать на страницу, содержащую полезную для него информацию.

Если Колибри на сайте обнаружит некачественный переоптимизированный контент, то будет опускать его позиции.

Не нужно пытаться обмануть Колибри. Он умеет определять смысл поисковой фразы и сравнивать ее с содержимым на сайте.

Официальное название Google Maccabees. Модификация алгоритма 2017 года. Создан для выявления страниц с низкосортным контентом, не соответствующим требованиям поисковика.

Для сайтов с таким контентом органический трафик стал снижаться до 90%. Под Фред попали сайты с текстами:

Переизбыток баннерной рекламы и откровенный копипаст также привлекали внимание Фреда. Чтобы избежать его внимания нужно размещать уникальный контент, использовать легальные методы продвижения и не спамить ключами.

Фильтр “Битые ссылки” отслеживает количество страниц с кодом 404. Чем больше таких страниц на ресурсе, тем ниже его позиции в поисковой выдаче.

Появляются такие страницы в результате удаления страниц, смене названий подразделов и разделов. В результате имеющиеся внутренние ссылки приводят на несуществующие страницы.

Для проверки нахождения ресурса под Broken links необходимо через Screaming Frog или панель мастеров выгрузить неработающие ссылки и скрыть при помощи тега nofollow.

В качестве профилактики возникновения “Битых ссылок” изменяя адреса страниц необходимо 301 редирект перенастроить на новые ссылки. Необходимо регулярно выполнять техническую проверку сайта и чистить его от несуществующих страниц и ссылок.

Более известное название “Ссылочная помойка”. Также является частью алгоритма. Нацелен на сайты, торгующие местами для ссылок на своих страницах. Если на одной странице размещено более пяти тематически не связанных ссылок сайт теряет позиции в выдаче, а страницы удаляются из индекса.

Для проверки ресурса через Screaming Frog выгружаются внешние ссылки. Далее производится их проверка и очистка. Нетематические ссылки можно закрыть атрибутом rel=nofollow. Делается переадресация на страницу, заблокированную в robots.txt.

Во избежание попадания под links не следует размещать некачественные ссылки разнотематических ресурсов.

Фильтр “Социтирование”. Под него попадают сайты, на которые ссылаются нетематические ресурсы. Проблема возникает при неграмотном выборе площадок-доноров и без учета их тематики.

Также под Co-citation linking filter смогут попасть ресурсы, закупающие ссылки на спамных сайтах. Как правило это площадки с низким трастом и размещающие ссылки на разноплановые ресурсы.

В таблице показаны методы проверки и выхода из-под “Социтирования”

| Причина | Как определить и устранить | Профилактические меры |

| Рост количества внешних ссылок. | Экспортировать и проверить ссылки через сервис checktrust. При обнаружении некачественных ссылок отключить их через Disavow Links. Отправить запрос на пересмотр. |

Составить нормальный график наращивания ссылочной массы. |

| Размещение донорских ссылок на спамных сайтах. | Отказаться от покупки спамных ссылок. Регулярно проверять имеющийся профиль. |

Представлен в 2012 году и анализирует прямые вхождения в домен коммерческих ключевых фраз.

Предполагалось, что коммерческие ключи в домене способствовали повышению позиций в поисковой выдаче. С момента выхода EMD это перестало работать. При наложении этого фильтра в топ выдачи сайт попадает с трудом. однако полного ухода из выдачи не будет, поскольку для ранжирования имеют значение и другие факторы.

Для проверки и выхода из-под фильтра необходимо заменить домен с редиректом 301.

Выбирая доменное имя использовать только одной ключевое слово.

Фильтр появился в 2012 году и отслеживает сайты, на которые были поданы жалобы за нарушение авторских прав. В некоторой степени Pirate похож на Панду.

При попадании под санкцию страница с копированным контентом может быть исключена из поисковой выдачи. В случае большого количества жалоб фильтр может быть наложен на весь сайт.

В случае попадания ресурса под Пирата необходимо удалить скопированный контент и заменить его собственным, уникальным. Размещение ссылки на первоисточник не всегда помогает в этой ситуации.

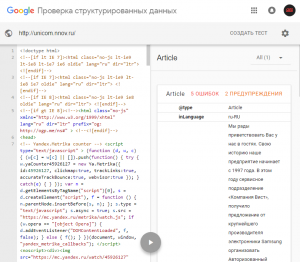

Фильтр запущен в марте 2015 г. Может использоваться как в ручном режиме, так и алгоритмически. Отслеживает разметку структурированных данных. При наложении санкции владелец ресурса получает уведомление в Search Console.

Возможные нарушения в микроразметке:

В результате работы фильтра из выдачи пропадают все расширенные сниппеты сайта. Возникнут трудности с индексацией размеченного контента.

Выйти из-под фильтра можно путем внесения в микроразметку изменений, соответствующих требованиям, предъявляемым поисковиком. В Search Console необходимо провести анализ статистики, содержащейся в отчете о “Структурированных данных”. Устранить ошибки в проблемных страницах и перепроверить результат при помощи Structured Data Testing Tool.

В случае наложения ручных санкций их отмена производится также вручную. После устранения замечаний необходимо подавать повторную заявку на рассмотрение в службу поддержки. Срок рассмотрения около недели.

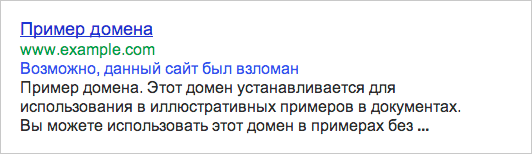

Это не фильтр. Подобное сообщение поступает в Search Console. Увидеть его можно в разделах “Проблемы безопасности” или “Меры, принятые вручную”. Происходит это в случае обнаружения поисковиком взломанных страниц.

Выглядеть это может примерно так.

После устранения проблем можно отправить запрос в администрацию поисковика на повторную проверку. Результат проверки будет отображаться в Search Console. Сотрудники Google убедятся в отсутствии проблем, после этого уведомление о взломе будет удалено и снят фильтр.

Санкции наступают на искусственные исходящие или входящие ссылки.

При входящих ссылках срабатывает ручной алгоритм Penguin.

Если размещены купленные исходящие ссылки, то приходит уведомление в Search Console.

После устранения недочетов подается заявка на снятие санкций.

Спам от пользователей может содержаться на форумах, в комментариях, блогах и даже в личных профилях. По этой причине из индекса могут быть исключены как отдельные страницы, так и полностью сайт.

Для устранения проблемы необходимо удалить:

Для устранения спама в поисковой строке Гугл нужно ввести site:название сайта + запрос, не относящийся к вашему контенту.

После этого отправляется запрос на проверку и снятие санкций.

Санкции могут наступить за скрытый текст на страницах сайта или за большое число ключевых слов. В результате срабатывания фильтра из поисковой выдачи удаляются отдельные страницы или полностью ресурс.

Для снятия фильтра необходимо воспользоваться инструментом из Search Console “ Просмотреть как Googlebot”. Это даст возможность взглянуть на контент со стороны поискового робота, а не пользователя.

Далее следует:

После этого подается заявка на повторную проверку.

Применяется в случае показа посетителям не тех страниц, которые видит поисковик или переадресации на недоступную для поискового робота страницу.

Важно! При размещении контента с платным доступом необходимо использовать микроразметку. В противном случае поисковик расценит это как замаскированный контент.

Для снятия фильтра требуется выполнить действия, описанные в разделе “Скрытый текст / Избыточное количество ключевых слов”.

Дополнительно нужно удалить перенаправления по JavaScript и после этого отправить запрос на повторную проверку и снятие санкций.

Нарушением также считается скрытая переадресация на мобильный версиях. В этом случае санкции накладываются в ручном режиме. Устраняется нарушение аналогично описанному выше методу.

Санкция применяется к визуальному контенту, если наблюдается его несовпадение в поиске и на сайте. Такой контент исключается из поиска по картинкам.

Для устранения санкции требуется:

После исправления недочетов отправить заявку на пересмотр и снятие санкций.

Агрессивный спам ― это размещение текста, не имеющего смысла, замаскированного или неуникального.

При срабатывании фильтра из поиска пропадают отдельные страницы или ресурс целиком.

Снятие санкции происходит через удаление нарушающего рекомендации Google контента.

Санкция накладывается на сайты, содержащие:

Фильтр скрывает из поиска отдельную страницу или целый ресурс.

Снимается санкция аналогичным с предыдущими спамными фильтрами методом. Необходимо удалить с ресурса автоматически созданные страницы и дорвеи. Создать контент, полезный для посетителей.

Отправить повторную заявку на рассмотрение.

При использовании AMP-страниц на канонической и AMP-версии содержание должно быть одинаковым, и они должны ссылаться друг на друга.

Допускаются некоторые различия в формулировках текста, то темы и функции страниц должны совпадать. В противном случае поисковиком будут приняты соответствующие меры: ускоренные страницы в отображении будут заменены на канонические.

Для снятия санкции потребуется устранить технические разногласия между AMP-страницами и каноническими.

При помощи инструмента проверки URL убедиться в одинаковом отображении страниц для робота и пользователей.

Проверить robots.txt на отсутствие взаимных блокировок важных ресурсов.

Подать заявку на проверку.

К неофициальным фильтрам относятся те, наличие которых не было официально подтверждено руководством Гугл. В тоже время работа этих фильтров была зафиксирована SEO-специалистами.

В случае использования в продвижении ресурса методов “черного SEO”, будет наблюдаться снижение позиций на определенное количество пунктов: -5, -30, -950.

Применяться фильтр может в отношении клоакинга, применения SEO-ссылок и скрытых редиректов, дорвеи.

Отличие неофициальных фильтров от остальных в том, что если сразу проигнорировать их устранение, то вначале произойдет потеря позиций, а затем полное исключение из индексации.

По заявлению самого Google пожизненный бан для сайтов не применяется. При своевременном обнаружении владельцем проблем, оперативном их устранении санкции снимаются автоматически.

Важно в работе с сайтом использовать белые методы продвижения.

Невозможно исправить положение, если ресурс имеет солидный шлейф фильтров и репутацию спамера. Единственным выходом будет перенос сайта на другой домен. Иначе такой объем проблем можно решать годами.